Материалы по тегу: microsoft azure

|

07.08.2024 [00:53], Владимир Мироненко

В третий раз за три недели: в Microsoft Azure снова произошёл глобальный сбойУ Microsoft пятого августа произошёл новый сбой в работе облака Azure, затронувший несколько сервисов для клиентов в Северной и Латинской Америке, пишет ресурс BleepingComputer. По словам компании, проблемы начались около 18:22 UTC (21:22 мск) и повлияли на сервисы, использующие облачную CDN-службу Azure Front Door (AFD). Как сообщила Microsoft, инцидент был вызван «изменением конфигурации». «Мы откатили это изменение, и с 19:25 UTC (22:25 мск) в большинстве сервисов наблюдается восстановление», — рассказала компания. BleepingComputer отметил, что в Великобритании клиенты также сообщали об ошибках при подключении к сервисам Azure (включая Azure DevOps), а на странице состояния Azure DevOps было отмечено, что проблемы коснулись и пользователей из Бразилии. На сайт Downdetector пришли тысячи сообщений пользователей о проблемах с подключением к серверам и входом в систему, хотя на странице состояния работоспособности службы (Service Health Status) не было указано никаких проблем с Azure на протяжении всего сбоя.

Источник изображения: techcommunity.microsoft.com На прошлой неделе Microsoft столкнулась с более продолжительным сбоем, который был вызван DDoS-атакой, нацеленной на несколько сайтов Azure Front Door и CDN. «Хотя первоначальным событием-триггером послужила DDoS-атака, которая активировала наши механизмы защиты от DDoS, первоначальное расследование показало, что ошибка в реализации нашей защиты усилила воздействие атаки, а не смягчила его», — заявила Microsoft.

01.08.2024 [16:34], Владимир Мироненко

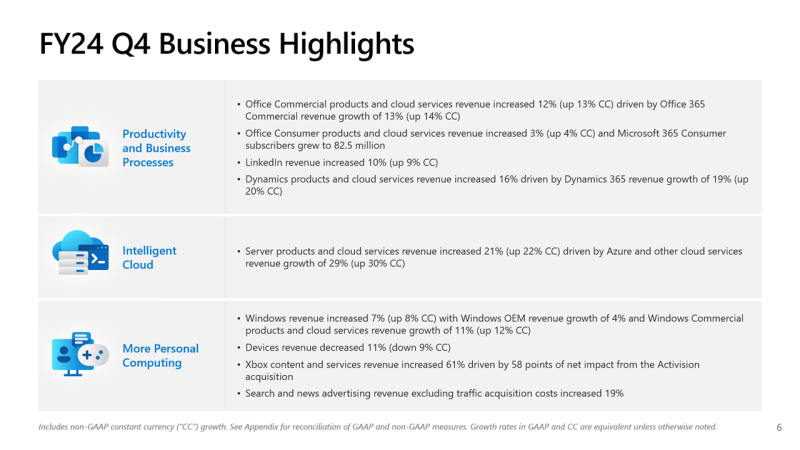

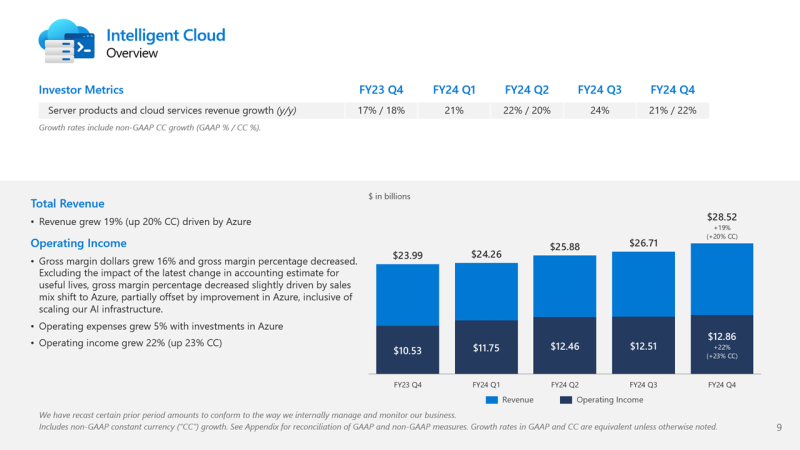

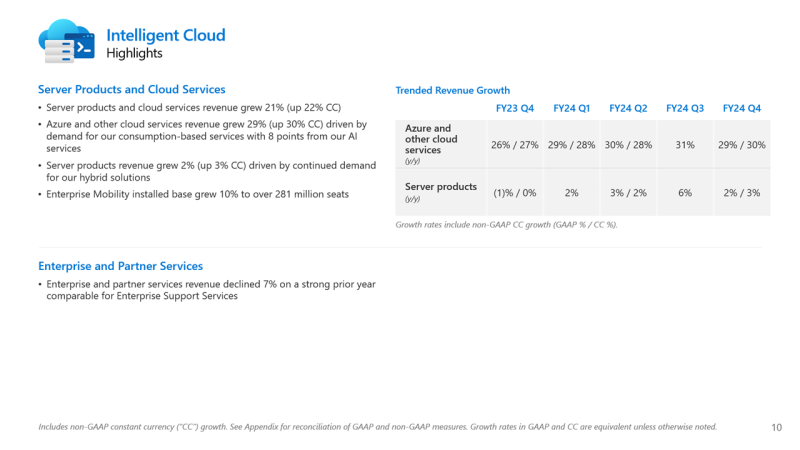

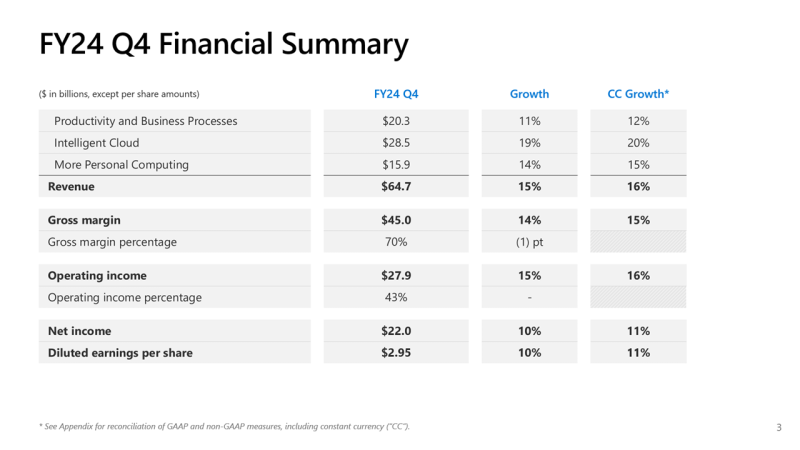

Почти половина выручки Microsoft теперь приходится на облачные сервисы, а четверть дохода Azure OpenAI принёс TikTokMicrosoft сообщила о результатах работы в IV квартале 2024 финансового года, завершившемся 30 июня. Несмотря на то, что выручка и прибыль Microsoft превысили прогнозы аналитиков, акции компании упали более чем на 7 % после публикации отчёта из-за недовольства инвесторов замедлением темпов роста облачной платформы Azure. На облачные сервисы теперь приходится около 45 % выручки корпорации. Microsoft сообщила о прибыли (GAAP) на акцию (EPS) в размере $2,95 при выручке в $64,73 млрд, превысившей показатель аналогичного квартала годом ранее на 15 %. Чистая прибыль компании увеличилась с $20,08 до $22,04 млрд. Согласно прогнозу аналитиков, опрошенных Bloomberg, показатели по прибыли и выручке могли составить $2,94 на акцию и $64,5 млрд. В IV квартале 2023 финансового года у Microsoft была прибыль на акцию в размере $2,69 и выручка в $56,19 млрд. Общий доход Microsoft от облачных вычислений составил $36,8 млрд, что полностью соответствует прогнозу Уолл-стрит, но выручка подразделения Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, оказалась ниже ожиданий аналитиков, составив $28,52 млрд (рост год к году на 19 %) при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $28,68 млрд. По данным Microsoft, на создание ЦОД и вычислительной инфраструктуры для обработки ИИ было израсходовано $13,9 млрд, что на 55 % больше, чем годом ранее. Компания заявила, что увеличение расходов было обусловлено более высокими доходами от ИИ, при этом спрос продолжает превышать предложение. Доход от Azure и других облачных сервисов вырос за квартал на 29 %. Аналитики, опрошенные CNBC и StreetAccount, ожидали рост на 31 %. При этом показатель Microsoft Azure не отставал от консенсус-прогноза с 2022 года. Абсолютные цифры в этой категории компания не раскрывает. Финансовый директор Эми Худ (Amy Hood) объяснила небольшое отставание облачного сегмента «слабостью в нескольких европейских географических регионах в плане потребления сервисов без ИИ». Как ожидает компания, эта тенденция сохранится в первой половине 2025 финансового года. Генеральный директор Microsoft Сатья Наделла (Satya Nadella), что количество клиентов Azure AI выросло на 60 %, и на 50 % увеличилось числа заказчиков ИИ, которые также используют аналитические инструменты Microsoft. Всего более 480 000 организаций использовали возможности ИИ на платформе Microsoft. По словам Наделлы, аудитория пользователей Microsoft Copilot удвоилась по сравнению с предыдущим кварталом. Он сообщил, что с нынешними темпами роста выручка GitHub превысит $2 млрд за год, что 40 % больше, чем в прошлом году. Добавим, что согласно данным ресурса The Information, ссылающегося на внутреннюю информацию компании, примерно четверть выручки Azure OpenAI принёс сервис коротких видео TikTok, чьи ежемесячные поступления составляли около $20 млн по состоянию на март 2024 года. По оценкам, служба Azure OpenAI принесёт $1 млрд за год или $83 млн в месяц. Интересно, что теперь OpenAI с точки зрения Microsoft является конкурентом, хотя IT-гигант и владеет почти половиной ИИ-компании. Продажи подразделения Microsoft Productivity and Business Processes выросли за отчётный квартал на 11 % до $20,3 млрд, превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в $20,13 млрд. Подразделение More Personal Computing принесло на 14 % больше дохода, составившего $15,90 млрд при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $15,49 млрд. Microsoft прогнозирует рост выручки Azure в I квартале 2025 финансового года в пределах 28–29 %, с более быстрым ростом во II половине финансового года, сообщила Худ. Согласно прогнозу Microsoft, выручка в I квартале 2025 финансового года составит от $63,8 млрд до $64,8 млрд, что подразумевает рост на 13,8 % в середине диапазона. Аналитики, опрошенные LSEG, прогнозируют $65,24 млрд дохода. Прогноз компании включает $15,25 млрд операционных расходов в середине диапазона, при консенсус-прогнозе StreetAccount в $16,10 млрд.

30.07.2024 [21:49], Руслан Авдеев

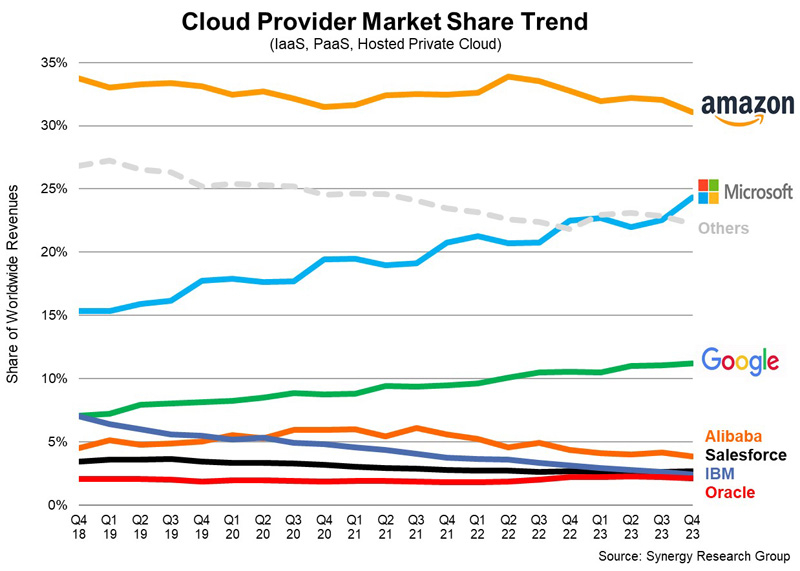

«Мутят воду»: Microsoft обвинила Amazon и Google в том, что они прикидываются слабыми и беспомощными перед британским регулятором CMAMicrosoft обвнили конкурентов Google и Amazon в том, что те «мутят воду», фактически мешая антимонопольному расследованию в Великобритании, передаёт ComputerWeekly. Соответствующие заявления представлены в публичном обращении Microsoft к британскому регулятору Competition and Markets Authority (CMA). В документах CMA за июнь 2024 года высказано предположение о том, что практика лицензирования продуктов и сервисов Microsoft может ослабить конкуренцию между облачными компаниями в Великобритании — использование лицензионного ПО Microsoft в облаках сторонних бизнесов может быть более дорогим для клиентов и повлиять на конкурентоспособность других облачных провайдеров. Google и AWS неоднократно жаловались британскому регулятору на Microsoft. В материалах Google, посвящённых расследованию, указывается, что практика лицензирования Microsoft ослабляет конкурентов и увеличивает их издержки. Искусственные ограничения делают ПО Microsoft слишком дорогим для использования в сторонних облаках, а конкуренты не могут противопоставить что-либо значительным ценовым различиям. В Google Cloud подчёркивают, что облака помогают цифровой экономике Великобритании, но недобросовестные механизмы лицензирования не дают клиентам свободу выбора и не позволяют внедрять инновации. Аналогичной позиции придерживается и AWS. Компания заявила, что единственным исключением из хорошо действующего рынка IT-услуг Великобритании является именно практика лицензирования Microsoft. В Amazon с оптимизмом смотрят на эволюцию взглядов CMA на предоставление британским пользователям гарантий свободного выбора облака для запуска популярных приложений Microsoft. В самой Microsoft оспаривают заявления и подчёркивают, что ни Google, ни AWS не страдают в той степени, как пытаются изобразить. В Microsoft утверждают, что её условия лицензирования ПО не ведут к существенному повышению затрат при использовании облаков конкурентов. Также заявлено, что бизнесы Amazon и Google, судя по всему, достаточно маржинальны, чтобы получать прибыль даже в условиях конкуренции. В компании напомнили, что капитальные затраты обоих конкурентов составляют $50 млрд и $30 млрд соответственно — это само по себе свидетельствует об их уверенности в прибыльности и конкурентоспособности. Так что речь идёт вовсе не об ослабленных, лишённых надежды конкурентах, какими пытаются представить себя компании, якобы не способные оплатить масштабное использование её интеллектуальной собственности, говорит Microsoft. Более того, за последние пару лет выручка Google и AWS только росла — это плоды конкуренции, а не её отсутствия. В Microsoft прямо заявили, что соперничество не бывает «мягким» или «слабым» — компании «бьют друг друга изо всех сил». По мнению IT-гиганта, Amazon, Google и CISPE попросту «мутят воду» в вопросе определения правильной и неправильной конкуренции. Расследование CMA было начато в октябре 2023 года, крайний срок его завершения — 4 апреля 2025 года. Недавно Microsoft после переговоров добилась примирения с CISPE, согласившись выплатить компенсацию в размере $22 млн в обмен на отказ мелких облачных операторов от претензий к ней. При этом новые правила лицензирования Microsoft в Европе не коснулись AWS, Google Cloud Platform и Alibaba Cloud. Впоследствии выяснилось, Google пыталась предложить CISPE более значимую компенсацию в обмен на продолжение тяжб с Microsoft.

30.07.2024 [21:48], Владимир Мироненко

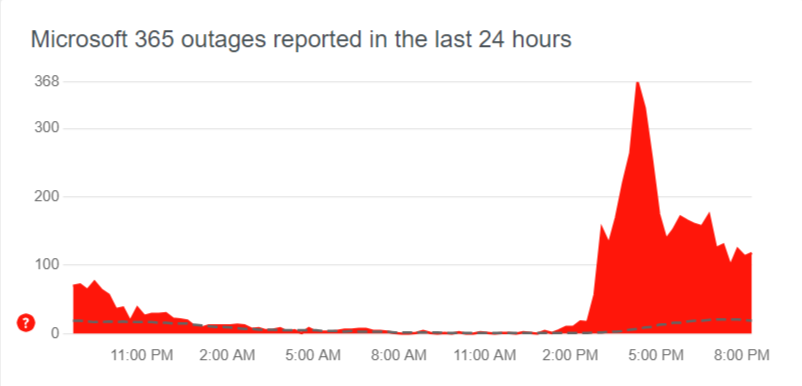

В облаке Microsoft Azure снова произошёл глобальный сбой, затронувший Microsoft 365, Teams, OneDrive, Minecraft и Xbox Live [Обновлено]Microsoft столкнулась с новым глобальным сбоем облака Azure, затронувшим целый ряд служб — от почтового сервиса Outlook до популярной игры Minecraft. Также пользователи по всему миру сообщают о трудностях с подключением к облачной платформе Azure и проблемах в работе с Microsoft 365, Teams, OneDrive и Xbox Live. «В настоящее время мы изучаем проблемы с доступом и снижение производительности нескольких сервисов и функций Microsoft 365», — отреагировали на обращения пользователей в Microsoft. Согласно странице статуса Azure, сбой начался в 11:45 UTC (14:45 мск), когда у целого ряда клиентов возникли проблемы с подключением к службам Microsoft по всему миру, включая Америку, Азиатско-Тихоокеанский регион, Европу и Ближний Восток. Компания сообщила, что внесла изменения в конфигурацию сети, а также задействовала альтернативные маршруты.

Источник изображения: Downdetector Доступность служб повысилась примерно с 14:10 UTC (17:10 мск), но полностью сбои пока не устранены. В частности, сейчас по всему миру всё ещё наблюдаются проблемы с сервисами CDN и Azure Front Door. Напомним, что совсем недавно в облаке Microsoft Azure произошёл масштабный сбой, совпавший во времени с глобальным сбоем из-за неудачного обновления защитного ПО компании CrowdStrike для ПК на Windows, обрушившего работу многих компаний и служб. UPD 31.07.2024: Microsoft объяснила восьмичасовой сбой своего облака масштабной DDoS-атакой. Точнее говоря, проблемой в механизме защиты Azure от таких атак, который вместо того, чтобы отразить DDoS, только ухудшил ситуацию с доступностью сервисов.

25.07.2024 [15:45], Руслан Авдеев

Lumen расширит оптические каналы связи между ИИ ЦОД Microsoft, а сама частично переедет в AzureКомпания Microsoft совместно с магистральным провайдером Lumen Technologies (прежде CenturyLink) объявили о намерении масштабировать пропускную способность каналов связи между дата-центрами техногиганта. По данным The Register, на такие меры Microsoft намерена пойти из-за расширения бизнеса, связанного с ИИ-технологиями. В рамках нового проекта Microsoft будет применять технологию частных сетей Private Connectivity Fabric компании Lumen, а общая пропускная способность между работающими с ИИ-нагрузками дата-центрами будет увеличена благодаря комбинации существующих и новых оптоволоконных линий. Стремление Microsoft нарастить технологические возможности вполне объяснимо — компания рассчитывает получить максимальную отдачу от инвестиций в OpenAI и другие ИИ-стартапы. Поэтому IT-гигант пытается интегрировать ИИ почти во все свои продукты. При этом необходимо обрабатывать и передавать огромные объёмы данных, для чего существующей сетевой инфраструктуры ЦОД уже не хватает. Впрочем, пока неизвестно, какую дополнительную ширину каналов обеспечит Lumen для Microsoft. Сами партнёры сотрудничество пока не комментируют.

Источник изображения: Lumen Technoligies При этом Lumen в рамках сделки обязалась перенести часть рабочих нагрузок в облако Microsoft Azure. Вероятно, ИИ-инструменты Microsoft будут интегрированы и в продукты Lumen. Кроме того, вероятно использование Lumen платформы Microsoft Entra, обеспечивающей управление идентификацией и контролем доступа. В Lumen рассчитывают, что подобная миграция позволит компании экономить более $20 млн уже в следующем году и повысить уровень обслуживания клиентов — не исключено, что часть функций компания передаст чат-ботам Microsoft на основе технологий OpenAI.

25.07.2024 [09:59], Сергей Карасёв

OpenAI намерена потратить до $7 млрд на обучение ИИ в 2024 году, потеряв при этом $5 млрдЗатраты OpenAI на обучение ИИ-моделей и задачи инференса в 2024 году, по сообщению The Information, могут составить до $7 млрд. При этом компания может зафиксировать денежные потери в размере $5 млрд, что вынудит её искать новые возможности для привлечения инвестиций. Как рассказали осведомлённые лица, OpenAI использует мощности, эквивалентные приблизительно 350 тыс. серверов с ускорителями NVIDIA A100. Из них около 290 тыс. обеспечивают работу ChatGPT. Утверждается, что оборудование работает практически на полную мощность. В рамках обучения ИИ-моделей и инференса OpenAI получает значительные скидки от облачной платформы Microsoft Azure. В частности, Microsoft взимает с OpenAI около $1,3/час за ускоритель A100, что намного ниже обычных ставок. Тем не менее, только на обучение ChatGPT и других моделей OpenAI может потратить в 2024 году около $3 млрд.

Источник изображения: pixabay.com На сегодняшний день в OpenAI работают примерно 1500 сотрудников, и компания продолжает расширять штат. Затраты на заработную плату и содержание работников в 2024-м могут достичь $1,5 млрд. Компания получает около $2 млрд в год от ChatGPT и может получить ещё примерно $1 млрд от взимания платы за доступ к своим большим языковым моделям (LLM). Общая выручка OpenAI, согласно недавним результатам, лежит на уровне $280 млн в месяц. В 2024 году, по оценкам, суммарные поступления компании окажутся в диапазоне от $3,5 млрд до $4,5 млрд. Таким образом, с учётом ожидаемых затрат в размере $7 млрд на обучение ИИ и инференс, а также расходов в $1,5 млрд на персонал OpenAI может потерять до $5 млрд. Это намного превышает прогнозируемые расходы конкурентов, таких как Anthropic (поддерживается Amazon), которая ожидает, что в 2024 году потратит $2,7 млрд. Не исключено, что OpenAI попытается провести очередной раунд финансирования. Компания уже завершила семь инвестиционных раундов, собрав в общей сложности более $11 млрд.

19.07.2024 [13:20], Руслан Авдеев

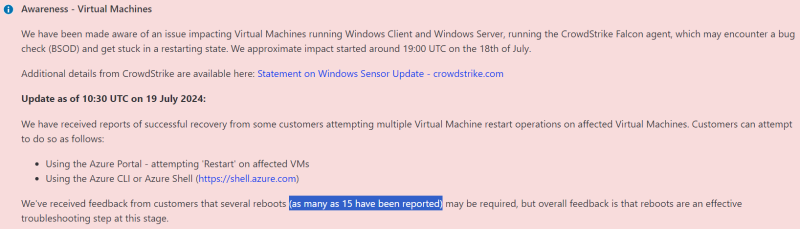

Беда не приходит одна: многочасовой сбой Microsoft Azure совпал с неудачным обновлением CrowdStrike, приводящему к BSODМасштабный сбой в облаке Microsoft Azure, наложившийся на неудачное обновление защитного ПО компании CrowdStrike для ПК на Windows привели к нарушениям работы критически важной инфраструктуры по всему миру. По данным Datacenter Dynamics, в результате пришлось прекратить полёты некоторым авиалиниям, остановить работу банков, больниц, магазинов и других критически важных организаций и сервисов. В Сети в шутку предложили назначить 19 июля Международным днём Синего экрана смерти Windows. Эксперты уже назвали данное событие крупнейшим IT-сбоем за всю историю. В Microsoft объявили, что облачный регион Central US спустя пять часов после сбоя вернулся к работе, хотя клиентам облака на восстановление работоспособности может понадобиться больше времени. Компания CrowdStrike, занимающаяся обеспечением кибербезопасности, также подтвердила, что выпущенное её обновление вызывало появление «экранов смерти» на компьютерах или бесконечной перезагрузке, а совпадение по времени двух не связанных с собой сбоев привело к тому, что клиентам теперь трудно определить, какая именно из причин вызвала неполадки в их инфраструктуре. Возможно, в некоторых случаях оказали влияние оба фактора. Сбои привели к тому, что авиакомпании приостановили полёты, частично прекратили функционировать аэропорты, железные дороги, банковские приложения и даже сервис Xbox Live прекратил работу на несколько часов. Пострадали и некоторые телеком-операторы и СМИ. Проблемы коснулись жителей США, Великобритании и Австралии, а также других стран, от Европы до Индии и Японии. CrowdStrike «откатила» дефектное обновление ПО Falcon Sensor, включавшее некорректный драйвер. В качестве временной меры предлагается удалить файлы вида C-00000291*.sys в директории C:WindowsSystem32driversCrowdStrike, загрузив Windows в безопасном режиме или режиме восстановления. Для облачных инстансов предлагается сделать то же самое, отмонтировав тома и сняв резервную копию. При наличии BitLocker понадобится ключ для дешифровки данных. Причём это не первая массовая проблема с ПО компании за последний месяц — более ранний апдейт приводил к 100 % загрузке одного из ядер CPU. Акции компании в преддверии сегодняшних торгов в США уже упали на 19 %. Аналитики полагают, что CrowdStrike в её нынешнем виде, возможно, перестанет существовать. По некоторым оценкам, поражено до 15 % корпоративных Windows-систем. Ситуация осложняется тем, что при отсутствии OOB придётся вручную исправлять проблему на каждом ПК. По неподтверждённым данным, в некоторых случаях помогает многократная последовательная перезагрузка ПК (до 15 раз подряд). Microsoft в свою очередь пояснила, что автоматизированный процесс управления внёс изменения в конфигурацию серверов, в результате чего была заблокирована связь между некоторыми хранилищами данных и вычислительными ресурсами в регионе US Central. Это привело к тому, что инстансы потеряли связь с виртуальными дисками, уходя в циклическую перезагрузку. Большинство сервисов сейчас восстановлено, но некоторые ещё испытывают «остаточное воздействие», клиенты получат поддержку на профильном портале Azure. В частности, проблемы всё ещё могут быть у пользователей и администраторов Microsoft 365.

18.07.2024 [12:34], Руслан Авдеев

Google попыталась «подкупить» облачные компании, чтобы они не прекратили жаловаться на Microsoft в ЕСКомпания Google обещала облачным бизнесам из Евросоюза компенсацию в объёме €470 млн ($512 млн) в попытке убедить их не отказываться от претензий к Microsoft. В своё время ассоциация CISPE пожаловалась на гиганта из Редмонда регуляторам ЕС, но позже стороны достигли соглашения, а жалоба была отозвана. Сама Google тоже жаловалась на поведение Microsoft регулятором ЕС. От своих претензий Cloud Infrastructure Services Providers in Europe (CISPE) отказалась на прошлой неделе — компании жаловались на проблемы с лицензированием ПО Microsoft при использовании в облаках вне Azure. Ранее в CISPE сетовали, что Microsoft чрезвычайно затруднила клиентам смену облачных провайдеров, фактически привязав своё ПО к сервисам Azure. Microsoft и CISPE урегулировали дело, но буквально за несколько дней до этого Google выдвинула встречное предложение — не отказываться от жалобы за крупную компенсацию. При этом Google предлагала в основном не деньги, а лицензии на облачное ПО на сумму €455 млн сроком на 5 лет и только €14 млн в виде реальной финансовой помощи. В своё время жалобу на Microsoft поддержала и AWS, но ничего не смогла сделать несмотря на то, что сама является членом CISPE.

Источник изображения: Blogging Guide/unsplash.com Ассоциация, куда входит множество малых провайдеров, решила пойти навстречу Microsoft, пообещавшей финансовую компенсацию в эквиваленте $22 млн и расширение возможностей по использованию приложений Microsoft в сторонних облаках. Компаниям будет обеспечен доступ к платформе Azure Stack HCI, что позволит запускать ПО Microsoft, по тем же ценам, что предлагает сам IT-гигант в Azure. Хотя Google долгое время отставала от Microsoft и AWS на облачных рынках, компания добилась значительных успехов в этой сфере. В I квартале облачный бизнес принёс компании $900 млн прибыли, при этом эксперты прогнозировали её на уровне $672,4 млн. Облачное подразделение Google рассматривается компанией как один из перспективных векторов для роста. Показатели можно было бы дополнительно улучшить, стимулировав интерес регуляторов к деятельности Microsoft — расследование в ЕС могло привести к оборотному штрафу в 10 % от глобальной выручки конкурента. У Microsoft большой опыт урегулирования подобных споров. Например, в 2004 году она выплатила более $9,75 млн поддерживаемой Google группе Computer and Communications Industry Association для того, чтобы та отказалась от претензий к Редмонду в ЕС. Хотя одной проблемой для Microsoft пока стало меньше, она ещё находится в поле зрения европейских властей в связи с вложением $13 млрд в OpenAI — под вопросом законность привилегированного использования последней облачных технологий Редмонда. Кроме того, Microsoft грозит в Евросоюзе крупный штраф за злоупотребление доминирующим рыночным положением — из-за привязки приложения Teams к другому ПО. Наконец, всё ещё ведутся антимонопольные расследования в Великобритании и США. В Соединённом Королевстве регулятор CMA изучает облачный рынок с 2023 года, а в США Microsoft и вовсе является фигурантом двух расследований. Первое начато в январе 2024 года и связано с изучением деятельности провайдеров ИИ-сервисов, второе посвящено Microsoft, OpenAI и NVIDIA — исследуется влияние трёх ключевых игроков на ИИ-индустрию.

15.07.2024 [21:20], Владимир Мироненко

Microsoft возглавила $40-млн раунд инвестиций в разработчика автономных микро-ЦОД Armada

armada

hardware

iiot

microsoft

microsoft azure

контейнер

микро-цод

модульный

облако

периферийные вычисления

финансы

Armada, стартап из Сан-Франциско (Калифорния, США), специализирующийся на разработке решений для периферийных вычислений, объявил об успешном раунде финансирования на $40 млн, который возглавил M12 (венчурный фонд Microsoft). С момента выхода в прошлом году из скрытого режима (stealth mode) стартап уже привлёк с учётом этой суммы более $100 млн инвестиций. В рамках инвестиционной сделки решения Armada появятся в маркетплейсе Azure Marketplace. Как сообщил стартап, это позволит клиентам Azure придерживаться выделенного бюджета на использование решений Armada и сделает его технологию «более доступной, чем когда-либо». Armada предлагает защищённые автономные модули ЦОД Galleon в стандартных 20′ и 40′ грузовых контейнерах, которые включают три и шесть стоек соответственно, платформу управления устройствами и вычислениями Edge и приложения Edge/AI, специально разработанные для использования на периферии и работающие локально или в облаке. Также Armada предлагает Commander Connect, комплексную платформу для мониторинга и управления IIoT-активами, включая терминалы Starlink, собственно ЦОД Galleon и другие подключённые устройства, такие как дроны, датчики, камеры и транспортные средства. Её основное назначение — предоставить доступ к интернету и облегчить удалённое или локальное управление экосистемой через «единое окно».

Источник изображения: Armada Как сообщает Armada, «используя надёжную инфраструктуру Azure, Commander Connect предлагает беспрецедентную масштабируемость, безопасность и производительность для периферийных вычислений корпоративного уровня». Стоимость использования Commander Edge начинается от $450 тыс./год, Commander Connect — $50 тыс./год. Ранее Armada объявила о партнёрстве с Halliburton, Pivotel, Edarat и Skydio, а также подписала соглашение с ближневосточной фирмой Edarat Group, занимающейся инженерным консалтингом в области ЦОД и облачных сервисов, о развёртывании 10 модулей Galleon в Персидском заливе и на Ближнем Востоке, уточняет DatacenterDynamics. При этом у Microsoft есть собственное предложение в этой области — микро-ЦОД Azure MDC в 40′ контейнере.

15.07.2024 [15:22], Руслан Авдеев

Microsoft «откупилась» от антимонопольного расследования Евросоюза, заключив сделку с CISPE в обход AWS и Google CloudMicrosoft сумела избежать длительного официального расследования деятельности своего облачного подразделения со стороны европейских регуляторов. По данным Bloomberg, после переговоров компания заключила соглашение с поддерживаемой AWS группой лоббистов CISPE, жаловавшейся европейским властям на лицензинонные соглашения Microsoft, условия которых затрудняли переход из её облака к конкурентам. Cloud Infrastructure Services Providers in Europe (CISPE), объединяющая провайдеров облачных сервисов, обязалась отозвать жалобу регуляторам ЕС — ранее объединение уверяло, что Microsoft чересчур крепко увязала использование собственного бизнес-ПО с облачными сервисами Azure. По словам президента Microsoft Брэда Смита (Brad Smith), консультации с CISPE велись больше года, но теперь решены не только прошлые проблемы, но и выработана стратегия совместного развития в будущем, благодаря чему Евросоюз и другие рынки станут ещё более конкурентными.

Источник изображения: Antoine Schibler/unsplash.com У Microsoft есть девять месяцев на то, чтобы предложить «более честные» условия лицензирования. Помимо выплаты $21,7 млн компенсаций за упущенные доходы и расходы на лицензии за последние два года, компания разработает специальную версию Azure Stack HCI для европейских облачных провайдеров, что позволит участникам CISPE запускать ПО Microsoft в своих облаках, платя те же деньги, что и клиенты Azure. Кроме того, для мониторинга ситуации CISPE создаст независимую структуру European Cloud Observatory. Еврокомиссии заявила, что оценит влияние сделки на конкуренцию на рынке ЕС. Впрочем, положением дел довольны не все. Некоторые провайдеры, не входящие в CISPE, хотели бы знать, будут ли сделаны денежные компенсации структурам, не входящим в ассоциацию. Они утверждают, что фактически могущественная компания заплатила торговому объединению за молчание и не намерена вносить фундаментальных изменений в своё ПО. Чрезвычайно важно, что смягчённые условия лицензирования не касаются AWS, Google Cloud Platform и Alibaba Cloud, отмечает DataCenter Dynamics.

Источник изображения: Synergy Research Group В AWS заявили, что соглашение никак не поможет подавляющему большинству клиентов Microsoft, которые всё ещё не смогут без лишних проблем использовать облака по своему усмотрению в Европе и по всему миру. В Google Cloud утверждают, что ищут другие возможности бороться с неконкурентными принципами лицензирования Microsoft в Европе. В своё время Google не только пожаловалась на Microsoft в Великобритании, но и сама отменила плату за перенос данных клиентов при их переходе к другому провайдеру. При этом AWS поддержала обвинения Google. В своё время европейские регуляторы уже начали расследование деятельности облачного гиганта. Хотя заявление CISPE было подано в ноябре 2022 года, своим происхождением жалоба, вероятно, обязана OVHcloud, которая ещё в 2021 году впервые направила соответствующую претензию. В 2022 гоуд к ней присоединилась Aruba IT, а чуть позже уже CISPE анонсировала поддержку антимонопольного дела. Ещё одним толчком стало вступление в силу закона Европейский закон о данных (EU Data Act), который должен упростить переход клиентов от провайдера к провайдеру. |

|